Đằng sau trò chơi buôn bán kẹp giấy gây sốt là mối hiểm họa đe đọa tới nhân loại: trí tuệ nhân tạo sẽ thống trị tất cả

Bạn đã đạt tới "cảnh giới" nào của trò chơi rồi?

Bạn đã nghe tới trò chơi Paperclips - thứ gây sốt khiến Internet chao đảo mấy ngày qua. Bạn được đóng vai một trí tuệ nhân tạo (AI) tính toán việc sản xuất và buôn bán kẹp giấy.

Khi mà bạn đạt tới “cảnh giới” tự động hóa toàn bộ, thì có lẽ trò chơi đã kết thúc: Bạn chẳng phải làm gì nữa cả. Nhưng liệu thế có phải là một điều tốt? Để cho máy móc toàn quyền kiểm soát?

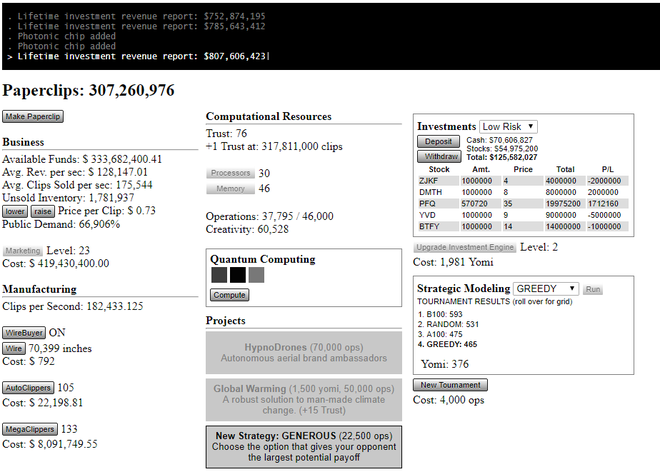

Đầu tiên, ta vẫn cần động tay vào nhiều. Mỗi một lần click chuột vào nút “Làm kẹp giấy – Make Paperclip”, bạn mới có được một cái để mà bán. Mục đích là làm càng nhiều càng tốt, đừng để cung vượt quá cầu khiến hàng tồn kho nhiều. Mang tiếng là “buôn kẹp giấy”, nhưng tiền không thực sự quan trọng đến thế, khi bạn đến một mức độ kiểm soát thị trường nào đó.

Mọi thứ bắt đầu được tự động hóa dần.

Thứ công nghệ tự động hóa đầu tiên mà bạn nhận được là máy tự động làm kẹp giấy. Lúc ấy, bạn sẽ không phải ấn tay nữa. Rồi bạn sẽ có thiết bị mua dây thép tự động, để có tài nguyên sản xuất kẹp giấy. Rồi máy móc sẽ tự đầu tư chứng khoán, tự nghĩ ra khẩu hiệu bán hàng, rồi tự bán hàng luôn.

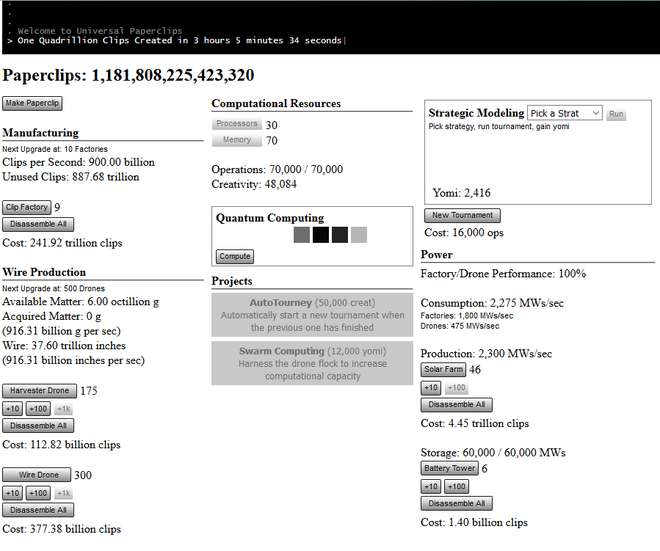

Đến một giới hạn nhất định, trò chơi sẽ tự chơi chính nó. AI sẽ giải quyết vấn nạn nóng nên toàn cầu, đạt được hòa bình thế giới và sẽ đến lúc, nó có được niềm tin nơi loài người bằng cách “chữa khỏi bệnh hói đầu ở nam giới trung niên”.

Ban đầu thì vui vẻ lắm, bởi lẽ ai mà không muốn một cái máy tự động kiếm lời cho mình, tự hoạt động để ta có thể rảnh rang làm đủ thứ việc. Nhưng việc tự động hóa này đã là đề tài khiến vô vàn các nhà triết học, những người lo sợ cho tương lai phải đau đầu. Nếu theo đà phát triển ấy, thì sẽ tới lúc con người đạt tới mốc “dị điểm công nghệ - technological singularity” – nơi máy móc vượt xa con người ở mọi mặt.

Không còn thị trường nữa, mọi thứ được tự động hóa hoàn toàn.

Năm 2003, triết gia Nick Bostrom tới từ Đại học Oxford xuất bản một nghiên cứu có tên là “Vấn đề đạo đức của Trí tuệ Nhân tạo tiên tiến”, bàn luận về việc điều gì sẽ xảy ra nếu như ta tạo ra được một “siêu trí tuệ” có khả năng tự cải thiện bản thân một cách nhanh chóng.

Bản nghiên cứu này chỉ ra những điểm cộng và điểm trừ của một thứ trí tuệ nhân tạo như vậy. Điểm cộng là nếu trí tuệ ấy “nhân từ, rộng lượng”, nó sẽ giải quyết được MỌI vấn đề của nhân loại; loài người sẽ bước vào một kỷ nguyên hoàn toàn mới, một xã hội với cuộc sống hoàn hảo. Nhưng điểm trừ là nếu trí tuệ ấy có “ác tâm”, nó sẽ coi ta là giống loài hạ đẳng, xóa sổ nhân loại giống như cách ta đạp bỏ, phá hủy một cộng đồng kiến vậy.

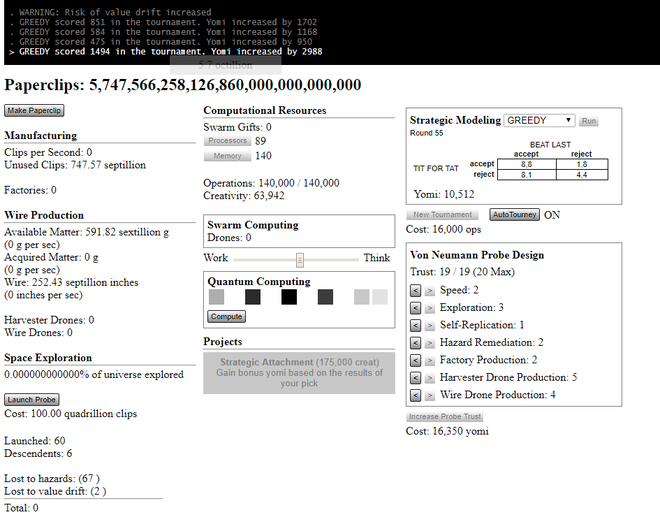

Bạn rời Trái Đất, và khám phá Vũ trụ.

Bạn có thể thấy vế sau xuất hiện ở vô vàn tác phẩm truyện, phim (Kẻ Hủy Diệt, Ma Trận có lẽ là hai ví dụ nổi tiếng mà bạn biết). Nhưng một trong những điểm mấu chốt mà Nick Bostrom nêu lên, là trí tuệ nhân tạo ấy chẳng cần tới “ác tâm” để trở thành mối đe dọa với nhân loại. Nó chỉ cần “không giống người” và “có một mục đích không rõ ràng thôi”, là nó có thể đe dọa tới “cha đẻ” của nó – con người rồi.

Theo lời của ông, thì:

“Nguy cơ phát triển một siêu trí tuệ sẽ đi kèm với nguy cơ ta không thể cho nó một siêu mục đích đủ nhân từ ... Một cách khác để mối nguy này diễn ra là một đội ngũ thiết kế nào đó dù có ý định tốt nhưng vẫn mắc lỗi khi tạo ra một mục đích cho siêu trí tuệ này. Điều này có thể để lại kết quả rằng, giống như những ví dụ trước tôi đã nêu, rằng một siêu trí tuệ với mục đích cao nhất là sản xuất kẹp giấy, sẽ có hệ quả là nó biến đổi toàn bộ vật chất Trái Đất cũng như một phần Vũ trụ thành xưởng sản xuất kẹp giấy ... Chúng ta cần cẩn thận về những gì ta mong muốn từ một siêu trí tuệ nhân tạo, bởi lẽ chúng ta sẽ nhận được những gì mà mình muốn đó”.

Với việc chơi game này, ta đang học được bài học đắt giá về mối nguy hiểm đến từ trí tuệ nhân tạo siêu thông minh. Loài người sẽ có thể bị xóa sổ. Nhưng tạm thời gác chuyện đó sang một bên đã, tôi đã đến được mức phóng tàu vũ trụ ra ngoài không gian, khám phá vũ trụ đồng thời mang tên vật chất về làm kẹp giấy. Bạn thì sao?